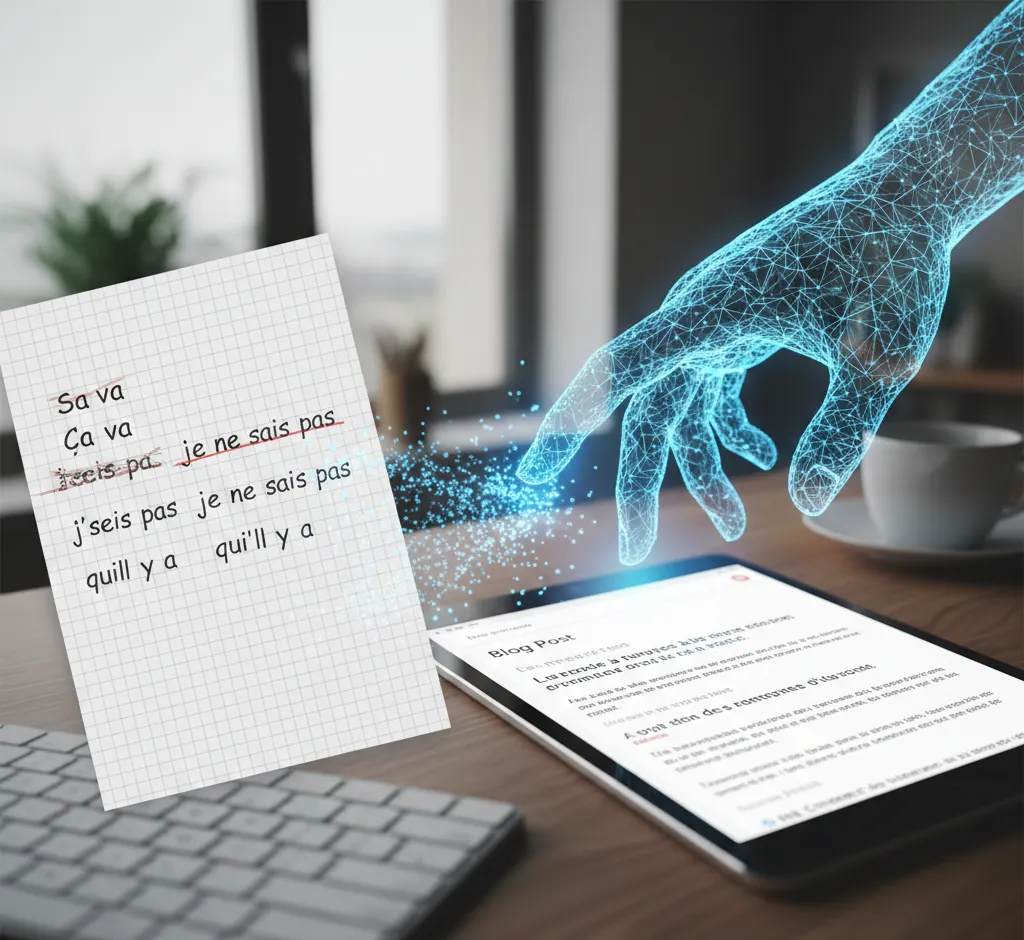

Traitement du langage naturel en développement : méthodes, outils et bonnes pratiques pour les développeurs

Découvrez comment intégrer le traitement du langage naturel (TLN / NLP) dans vos projets de développement : concepts clés, outils, modèles modernes, bonnes pratiques, performance et enjeux éthiques, avec des exemples concrets de cas d’usage.

Par Éloïse

Le traitement du langage naturel (TLN), ou Natural Language Processing (NLP), est devenu un pilier incontournable du développement logiciel moderne. Des chatbots aux moteurs de recherche internes, en passant par l’analyse de sentiments et la génération de contenu, le TLN transforme la manière dont les utilisateurs interagissent avec les applications.

Pour un développeur, comprendre les fondamentaux du TLN, connaître les principales bibliothèques et adopter de bonnes pratiques techniques et éthiques est désormais un véritable avantage compétitif. Dans cet article, nous allons explorer les concepts clés, les outils majeurs, les architectures modernes ainsi que des conseils pratiques pour intégrer le TLN dans vos projets.

1. Qu’est-ce que le traitement du langage naturel ?

Le traitement du langage naturel est un domaine de l’intelligence artificielle qui vise à permettre aux machines de comprendre, d’analyser, de générer et d’interagir avec le langage humain. Il se trouve à la croisée de l’informatique, de la linguistique et des statistiques.

Concrètement, un système de TLN prend en entrée du texte (ou de la voix convertie en texte), le transforme en représentation exploitable par un modèle, puis produit une sortie : une prédiction, une classification, un résumé, une réponse à une question, etc.

- Compréhension : analyse de sentiments, classification de texte, extraction d’entités.

- Génération : rédaction de textes, complétion automatique, dialogue.

- Interaction : chatbots, assistants virtuels, recherche conversationnelle.

Le TLN moderne repose largement sur l’apprentissage automatique, et plus récemment sur le deep learning et les modèles de type transformers, qui ont permis un saut de performance dans de nombreux cas d’usage.

2. Principales tâches du TLN en développement

Avant de choisir une bibliothèque ou une architecture, il est essentiel d’identifier clairement la tâche que votre application doit accomplir. Voici les tâches les plus fréquentes rencontrées en développement.

- Classification de texte : attribuer une catégorie à un texte (par exemple, "spam" ou "non-spam", thèmes d’un ticket support, type de demande).

- Analyse de sentiments : déterminer si un avis, un commentaire ou un message est plutôt positif, négatif ou neutre.

- Reconnaissance d’entités nommées (NER) : identifier dans le texte des entités comme des noms de personnes, des organisations, des lieux, des produits.

- Extraction d’information : repérer et structurer des informations pertinentes (dates, montants, identifiants) dans des textes libres.

- Résumé automatique : produire une version condensée d’un document tout en conservant les informations essentielles.

- Traduction automatique : traduire du texte d’une langue à une autre.

- Réponse aux questions : répondre de manière précise à une question en s’appuyant sur une base documentaire ou un contexte fourni.

Chaque tâche implique des approches et des modèles légèrement différents, même si les fondations techniques (transformers, embeddings, fine-tuning) sont souvent communes.

3. Pipeline de traitement : du texte brut au modèle

Un système de TLN ne se résume pas à un modèle unique. Il s’appuie sur un pipeline de traitement qui prépare le texte, l’encode et post-traite les résultats. Même avec les modèles modernes, il est utile de connaître cette chaîne de traitement.

- Collecte de données : récupération de textes à partir de logs, bases de données, fichiers ou API.

- Nettoyage : suppression du HTML inutile, des caractères non pertinents, normalisation des espaces, traitement des emojis si nécessaire.

- Tokenisation : découpage du texte en unités (tokens). Avec les transformers modernes, cette étape est souvent gérée automatiquement, mais reste centrale pour la performance.

- Représentation vectorielle : transformation des tokens en vecteurs numériques (embeddings) compréhensibles par le modèle.

- Modélisation : application d’un modèle de classification, de génération ou de ranking selon la tâche.

- Post-traitement : reconstruction de texte, filtrage, mise en forme pour l’affichage dans votre interface.

Pour un développeur, bien structurer ce pipeline permet de maintenir un code plus propre, de tester facilement chaque étape et de réutiliser les composants dans différents projets.

4. Outils et bibliothèques clés pour les développeurs

Le TLN moderne dispose d’un écosystème riche. La plupart des développeurs travaillent en Python, mais d’autres langages offrent également des solutions robustes. Voici les principaux outils à connaître.

- spaCy : une bibliothèque orientée production pour le TLN, rapide, simple à intégrer, avec des modèles pré-entraînés pour plusieurs langues. Elle propose la tokenisation, la NER, la lemmatisation, la détection de dépendances et des pipelines personnalisables.

- NLTK : un toolkit historique, très complet sur le plan académique (corpus, fonctions linguistiques), idéal pour apprendre, un peu moins orienté production.

- Hugging Face Transformers : la référence pour utiliser des modèles pré-entraînés (BERT, RoBERTa, GPT, T5, etc.). Permet de charger, fine-tuner et déployer des modèles state-of-the-art via une API unifiée.

- FastText : développé par Meta, utile pour les embeddings de mots et la classification rapide, notamment sur des langues peu dotées.

- OpenAI, Azure, AWS, Google Cloud : offres de modèles de langage accessibles via API, qui évitent de gérer l’infrastructure et permettent d’intégrer rapidement des fonctionnalités avancées.

Le choix dépendra du niveau de contrôle que vous souhaitez garder, des contraintes de confidentialité, des ressources matérielles (GPU ou non) et de la langue cible (français, anglais, multilingue, etc.).

5. Modèles de langage modernes : de BERT aux transformers génératifs

Depuis l’apparition de l’architecture transformer, le TLN a connu une révolution. Au lieu de traiter les mots séquentiellement comme les RNN, les transformers utilisent un mécanisme d’attention qui leur permet de prendre en compte le contexte global d’une phrase.

- BERT et dérivés : modèles principalement orientés compréhension (classification, NER, QA). Ils sont généralement utilisés en encodage du texte avant de prédire des labels.

- GPT-like : modèles génératifs auto-régressifs, excellents pour la complétion de texte, la rédaction assistée et la conversation.

- T5, BART : modèles seq2seq capables d’apprendre des tâches de transformation de texte (résumé, traduction, réécriture) via un paradigme "texte en entrée, texte en sortie".

- Modèles multilingues : comme XLM-R ou mBERT, utiles lorsque votre application doit gérer plusieurs langues sans multiplier les modèles.

Dans un contexte de développement, il est souvent plus économique et plus efficace de partir d’un modèle pré-entraîné et de le spécialiser (fine-tuning) sur vos données spécifiques, plutôt que de réentraîner un modèle complet depuis zéro.

6. Intégrer le TLN dans une application web ou mobile

Au-delà de la recherche et des notebooks, le défi pour un développeur consiste à intégrer le TLN dans une application réelle, performante et robuste. Plusieurs architectures d’intégration sont possibles.

- Microservice dédié au TLN : exposer vos modèles via une API REST ou gRPC. Votre application (front-end ou back-end principal) interroge ce service pour chaque requête NL.

- Intégration côté back-end : appeler directement les bibliothèques de TLN dans votre service principal. Adapté à des volumes modestes et à un déploiement simplifié.

- Appels à des API externes : utiliser les API de modèles hébergés (OpenAI, Hugging Face Inference API, services cloud). Cela réduit la charge d’infrastructure mais implique des coûts récurrents et des contraintes de confidentialité.

Pour chaque approche, pensez à la latence, au coût par requête, à la scalabilité et à la résilience. La mise en cache des résultats pour des textes fréquents ou des requêtes répétitives peut réduire significativement la charge.

7. Bonnes pratiques pour des modèles robustes

Construire un système de TLN robuste ne se limite pas à avoir un bon score de validation. Les conditions réelles d’exploitation sont souvent plus variées que les jeux de données d’entraînement. Voici quelques bonnes pratiques.

- Définir clairement le périmètre : préciser ce que le modèle sait faire et ce qu’il ne sait pas faire. Limiter les entrées acceptées si nécessaire.

- Nettoyer et normaliser les données : gérer les accents, les variations de casse, les fautes de frappe, les emojis et les abréviations courantes.

- Prévoir des mécanismes de fallback : si le modèle n’est pas confiant, renvoyer un message standard, escalader vers un humain ou transférer vers une recherche par mots-clés plus simple.

- Surveiller les performances en production : logger les requêtes, suivre des métriques (taux d’erreur, temps de réponse, taux de satisfaction utilisateur) et comparer régulièrement aux versions précédentes.

- Mettre à jour le modèle : réentraîner ou affiner le modèle avec des données plus récentes, notamment lorsque le langage ou les produits évoluent.

Une approche itérative, basée sur l’observation et l’amélioration continue, est souvent plus efficace qu’un entraînement unique sur un gros jeu de données statique.

8. Respect de la vie privée, biais et éthique

Le traitement du langage naturel manipule souvent des données sensibles : conversations, emails, tickets de support, évaluations clients. Pour un développeur, ignorer les enjeux de confidentialité et de biais peut conduire à des problèmes juridiques et de confiance.

- Anonymisation : avant d’entraîner un modèle, supprimer ou pseudonymiser les informations personnelles (noms, adresses, numéros de téléphone).

- Conformité réglementaire : respecter le RGPD (GDPR) et les lois locales, notamment en matière de consentement et de stockage de données.

- Gestion des biais : les modèles de langage reproduisent les biais présents dans leurs données d’entraînement. Tester explicitement vos modèles sur des cas sensibles (genre, origine, religion) et ajuster si nécessaire.

- Transparence : informer les utilisateurs qu’ils interagissent avec un système automatisé, surtout lorsqu’il s’agit de chatbots ou d’assistants virtuels.

Intégrer ces considérations dès la phase de conception évite des refontes coûteuses et contribue à instaurer une relation de confiance avec vos utilisateurs.

9. Exemples concrets de cas d’usage

Pour mieux visualiser ce que le TLN peut apporter à vos projets, examinons quelques cas d’usage typiques dans le développement d’applications.

- Support client automatisé : un chatbot capable de répondre aux questions fréquentes, de rediriger vers la bonne rubrique de la base de connaissances ou de créer un ticket si la demande est complexe.

- Analyse de feedback utilisateur : classification et analyse de sentiments des avis clients, des commentaires sur les réseaux sociaux ou des réponses à des enquêtes.

- Recherche intelligente : moteur de recherche interne utilisant la compréhension sémantique pour aller au-delà de la simple correspondance de mots-clés.

- Assistant de rédaction : suggestions de complétion, reformulations, vérification de ton ou de cohérence pour des outils de rédaction ou des CRM.

- Extraction documentaire : extraction automatique de données clés dans des contrats, factures, rapports ou e-mails, pour alimenter des systèmes métiers.

Ces exemples montrent que le TLN n’est pas réservé aux grandes entreprises technologiques : de nombreuses PME peuvent en tirer des gains de productivité et d’expérience utilisateur.

10. Choisir entre modèles hébergés et auto-hébergés

Un choix structurant pour un développeur consiste à décider s’il vaut mieux utiliser des modèles hébergés par un fournisseur cloud ou déployer ses propres modèles sur son infrastructure.

- Modèles hébergés (API) : intégration rapide, sans gestion d’infrastructure. Idéal pour des prototypes, des POC ou des petites équipes. En contrepartie, vous dépendez de la tarification, des limites de quotas et des politiques du fournisseur.

- Modèles auto-hébergés : davantage de contrôle sur les données, possibilité d’optimiser les coûts à grande échelle et d’adapter finement les modèles. En revanche, cela demande des compétences en MLOps, en déploiement de modèles et en gestion de GPU.

Dans la pratique, beaucoup d’équipes adoptent une approche hybride : API externes pour certaines fonctionnalités avancées, modèles internes pour les données les plus sensibles ou les tâches très spécifiques.

11. Conseils pour démarrer un projet de TLN

Si vous débutez en TLN, il est facile de se sentir submergé par la quantité de modèles, de frameworks et de bonnes pratiques. Voici un plan simple pour lancer un projet sans vous perdre.

- Commencer simple : démarrez avec une seule tâche bien définie (par exemple, classification de tickets support) et un modèle pré-entraîné.

- Utiliser des bibliothèques haut niveau : Hugging Face pour les modèles, spaCy pour les pipelines, afin de réduire la complexité du code.

- Construire un petit jeu de données annoté : même quelques centaines d’exemples bien annotés peuvent suffire à obtenir un gain significatif par rapport à un modèle générique.

- Mettre rapidement en production : déployez une première version, même imparfaite, pour obtenir des retours utilisateurs réels.

- Itérer : ajustez les prompts, affinez le modèle, améliorez le prétraitement des données et enrichissez le jeu d’entraînement.

Cette approche pragmatique vous permet d’apprendre progressivement tout en générant de la valeur concrète pour votre application.

12. Conclusion : le TLN comme compétence incontournable pour les développeurs

Le traitement du langage naturel est passé du statut de sujet de recherche complexe à celui d’outil accessible à tout développeur motivé. Grâce aux modèles pré-entraînés, aux bibliothèques haut niveau et aux API spécialisées, il est possible d’intégrer des fonctionnalités avancées en quelques dizaines de lignes de code.

Maîtriser les bases du TLN, connaître les principaux outils et comprendre les enjeux d’intégration, de performance et d’éthique vous permettra de concevoir des applications plus intelligentes, plus intuitives et plus proches des attentes réelles des utilisateurs.

Que vous souhaitiez créer un chatbot, améliorer un moteur de recherche interne, automatiser la lecture de documents ou analyser des milliers de commentaires, le TLN offre un ensemble de briques technologiques puissantes, prêtes à être intégrées dans vos futurs projets de développement.