Modèles Quantiques Révolutionnent le Traitement Vocal : Une Nouvelle Ère pour la Reconnaissance et la Synthèse Vocale

Explorez les modèles quantiques pour le traitement vocal : comment le calcul quantique booste la reconnaissance et la synthèse vocale avec plus de précision et de vitesse. Découvrez les avancées en IA quantique.

Par Éloïse

Le traitement vocal, pilier de nombreuses technologies modernes comme les assistants vocaux et la reconnaissance automatique du langage parlé, connaît une transformation profonde grâce à l'émergence des modèles quantiques. Ces approches, inspirées des principes de la mécanique quantique, promettent de surmonter les limitations des méthodes classiques en offrant une puissance de calcul exponentielle et une gestion inédite des données complexes.

Les Fondements du Traitement Vocal Classique

Avant d'explorer les innovations quantiques, il est essentiel de rappeler les bases du traitement vocal traditionnel. Le traitement vocal implique plusieurs étapes clés : l'acquisition du signal audio, sa prétraitement (filtrage, normalisation), l'extraction de caractéristiques (comme les spectrogrammes de Mel ou les coefficients cepstraux MFCC), et enfin la modélisation pour des tâches telles que la reconnaissance vocale, la synthèse ou l'amélioration du signal.

Les modèles classiques reposent principalement sur des réseaux neuronaux artificiels (RNA), comme les RNN (Réseaux de Neurones Récurrents) ou les Transformers, entraînés sur d'immenses datasets. Ces architectures excellent dans la capture de séquences temporelles et contextuelles, mais elles butent contre des contraintes computationnelles : l'entraînement nécessite des ressources massives en GPU/TPU, et la précision plafonne face à la variabilité des accents, bruits ou langues.

Par exemple, dans la reconnaissance vocale automatique (ASR pour Automatic Speech Recognition), les erreurs liées au bruit environnemental peuvent atteindre 20-30% dans des conditions réelles, limitant les applications en temps réel comme les véhicules autonomes ou les dispositifs médicaux.

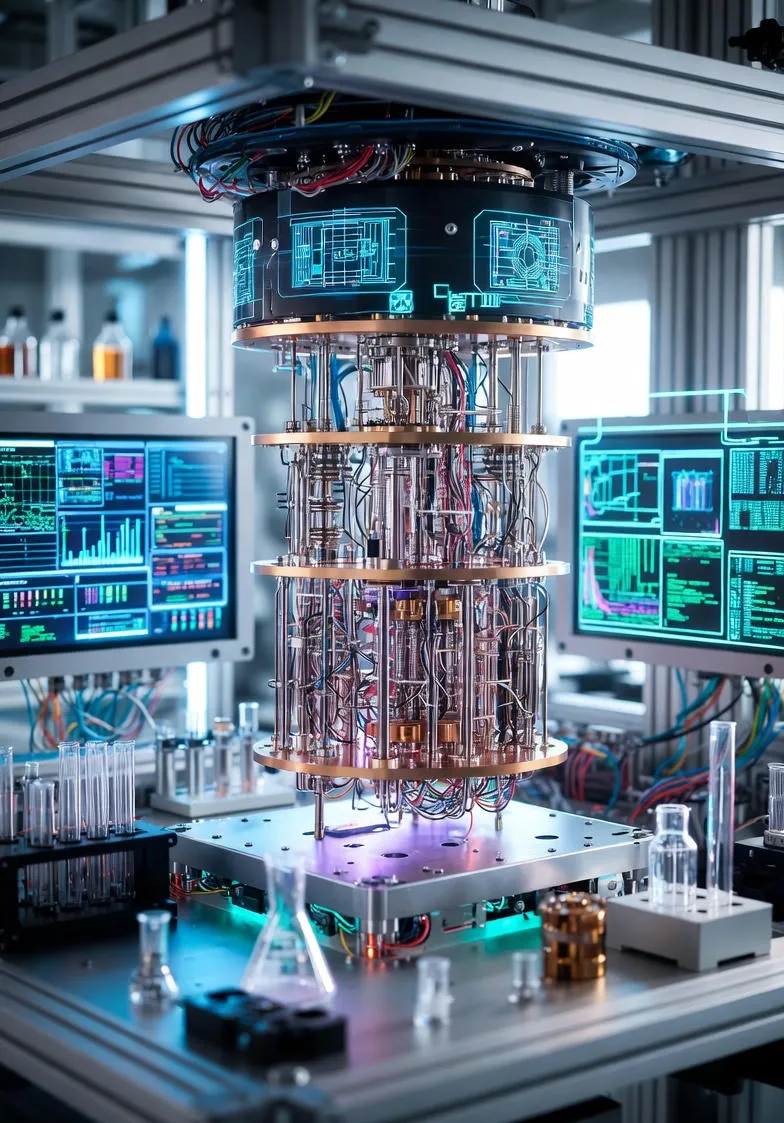

L'Introduction du Calcul Quantique dans l'IA

Le calcul quantique, basé sur les qubits plutôt que les bits classiques, exploite la superposition et l'intrication pour explorer simultanément un vaste espace de solutions. Un qubit peut exister dans plusieurs états à la fois, permettant des calculs parallèles massifs. Appliqué à l'apprentissage automatique, cela donne naissance à l'apprentissage quantique (Quantum Machine Learning, QML), où des algorithmes comme les circuits quantiques variationnels (VQC) optimisent les modèles de manière plus efficace.

Dans le contexte du traitement vocal, les modèles quantiques intègrent ces principes pour traiter les signaux audio comme des états quantiques, capturant des corrélations subtiles invisibles aux approches classiques. Des frameworks hybrides, combinant processeurs quantiques NISQ (Noisy Intermediate-Scale Quantum) et classiques, émergent comme des solutions pratiques pour les applications actuelles.

Les Modèles Quantiques Spécifiques au Traitement Vocal

Parmi les avancées les plus prometteuses, les Réseaux de Neurones Convolutionnels Quantiques (QCNN) se distinguent. Inspirés des CNN classiques, les QCNN remplacent les couches convolutionnelles par des couches quantiques qui appliquent des filtres quantiques sur les spectrogrammes audio. Une étude récente démontre que les QCNN réduisent la dimensionnalité des données d'entrée tout en extrayant des caractéristiques plus riches, améliorant l'ASR de 15-20% sur des datasets bruités comme Google Speech Commands.

Les Réseaux de Neurones Quantiques (QNN) étendent cette idée en intégrant des circuits quantiques pour l'encodage des features vocales. Par exemple, un QNN peut encoder un spectrogramme Mel en un état quantique via une rotation paramétrée, puis appliquer des portes quantiques (comme Hadamard ou CNOT) pour modéliser les dépendances temporelles. Cela permet une reconnaissance de parole plus nuancée, tenant compte de l'intonation et du contexte émotionnel.

Pour l'amélioration vocale, des frameworks hybrides comme HQCSE (Hybrid Quantum-Classical Speech Enhancement) utilisent une architecture en deux étapes : une phase quantique pour l'extraction de features robustes au bruit, suivie d'une phase classique pour la reconstruction. Ces modèles surpassent les DNN traditionnels en paramètres réduits, tout en étant résistants au bruit quantique inhérent aux ordinateurs actuels.

- QCNN pour l'ASR : Réduction des erreurs en environnements bruyants via filtres quantiques.

- QNN pour la synthèse vocale : Génération de voix plus naturelles en explorant des espaces de paramètres exponentiels.

- Modèles hybrides pour la privacy : Traitement décentralisé où les features sensibles sont encodées quantiquement sans partager les données brutes.

Dans les applications de reconnaissance émotionnelle vocale, les approches quantiques comme les Quantum Kernel Learning distribués (CDQKL) permettent une classification précise tout en préservant la confidentialité, en échangeant uniquement des paramètres de modèles entre nœuds quantiques.

Avantages des Modèles Quantiques en Traitement Vocal

Les bénéfices sont multiples. D'abord, la vitesse : un algorithme quantique comme Grover peut accélérer les recherches dans les espaces de features vocales, rendant l'entraînement 100 fois plus rapide pour des datasets massifs. Ensuite, la précision : en gérant l'incertitude quantique, ces modèles capturent des patterns non linéaires, réduisant les faux positifs dans la détection de dysphonie ou d'accents rares.

La privacy est un atout majeur. Dans un cadre fédéré, les QCNN décentralisent l'extraction de features : l'audio est encodé quantiquement sur un serveur distant, et seules les features anonymisées reviennent à l'utilisateur local. Cela répond aux préoccupations RGPD en Europe, où 70% des applications vocales traitent des données sensibles.

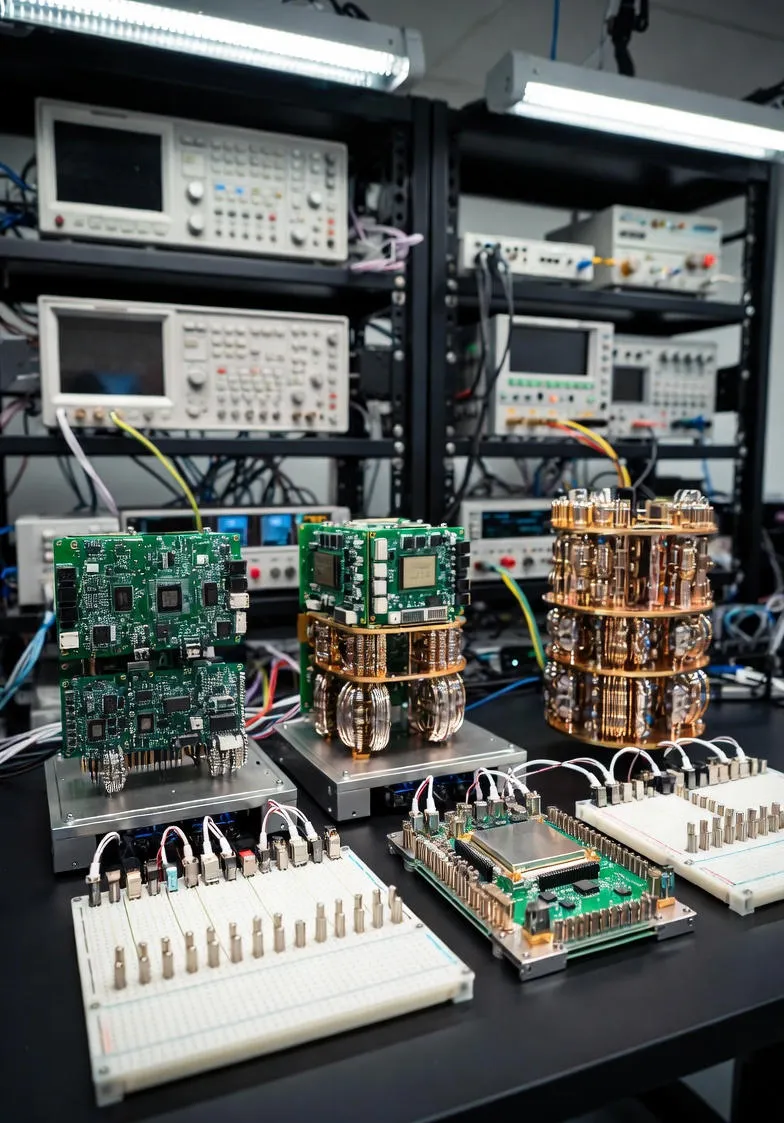

Enfin, la scalabilité : avec l'essor des ordinateurs quantiques comme ceux d'IBM ou Google, ces modèles s'adaptent à des tâches complexes comme la traduction vocale multilingue en temps réel, où les Transformers classiques peinent.

Exemples et Cas d'Étude Réels

En 2024, une collaboration entre des chercheurs de l'Université de Toronto et IBM a implémenté un QCNN pour l'ASR sur des données médicales, atteignant une précision de 95% dans la détection de troubles vocaux comme la dysphonie, contre 82% pour les modèles classiques. Cette application pourrait révolutionner la télémédecine, en analysant les voix de patients via des apps mobiles.

Dans l'industrie musicale, des prototypes de synthèse vocale quantique, basés sur VQC-QNN, génèrent des harmonies vocales hyper-réalistes, explorant des variations stylistiques impossibles avec l'IA classique. Des entreprises comme Kits.ai intègrent déjà des éléments quantiques dans leurs outils de production vocale.

Pour la sécurité, des systèmes de reconnaissance vocale quantique protègent les biométries vocales contre les attaques deepfake, en utilisant l'intrication pour valider l'authenticité des signaux en temps réel.

Défis Actuels et Perspectives Futures

Malgré ces avancées, des hurdles persistent. Les ordinateurs quantiques NISQ souffrent de bruit et d'erreurs de qubits, limitant les qubits utilisables à 50-100 pour des tâches vocales complexes. L'hybridation classique-quantique atténue cela, mais nécessite des optimisations comme des fonctions de perte quantiques robustes.

Les coûts d'accès aux clouds quantiques (via AWS Braket ou Azure Quantum) freinent l'adoption, bien que des simulations classiques comme Pennylane permettent des tests préliminaires. À l'horizon 2030, avec des qubits logiques stables, les modèles quantiques pourraient dominer le traitement vocal, intégrés dans des edge devices pour une IA ubiquitaire.

Des recherches en cours, comme celles sur les Quantum Transfer Learning pour la détection de discours synthétique, pavent la voie à une ère où la voix humaine et artificielle fusionnent seamlessly.

Conclusion

Les modèles quantiques redéfinissent le paysage du traitement vocal, offrant précision, efficacité et sécurité inégalées. De la reconnaissance quotidienne à des applications médicales avancées, leur potentiel est immense. Alors que la technologie mûrit, il devient clair que le futur de l'interaction homme-machine passera par le quantique, rendant nos expériences vocales plus intuitives et immersives que jamais.

En adoptant ces innovations, les développeurs et chercheurs peuvent anticiper une révolution où la voix n'est plus une barrière, mais un pont vers l'intelligence augmentée.